AI 问题发现

自动分析 MLflow 实验中的跟踪记录,以发现运维问题、质量问题和性能模式。Analyze Experiment 工具使用假设驱动的分析方法,系统地检查您的 GenAI 应用程序的行为,识别最重要的问题,并以全面的 markdown 报告的形式制定解决这些问题的计划。

概述

Analyze Experiment 命令会检查 MLflow 实验中记录的跟踪记录,以自动发现

运维问题

检测错误、超时、速率限制、身份验证失败和性能瓶颈

质量问题

识别过于冗长的响应、不一致的输出、重复的内容和不恰当的响应格式

成功模式

发现哪些方面运行良好、有效的工具使用情况和高质量的交互

性能指标

分析延迟分布、成功率和错误模式

该工具会生成详细的 markdown 报告,其中包含具体的跟踪示例、量化证据和可操作的改进建议。

用法

Analyze Experiment 功能可通过两种方式使用

分析工作流程

Analyze Experiment 工作流程

设置与身份验证

选择实验

确定代理目的

分析问题

生成报告

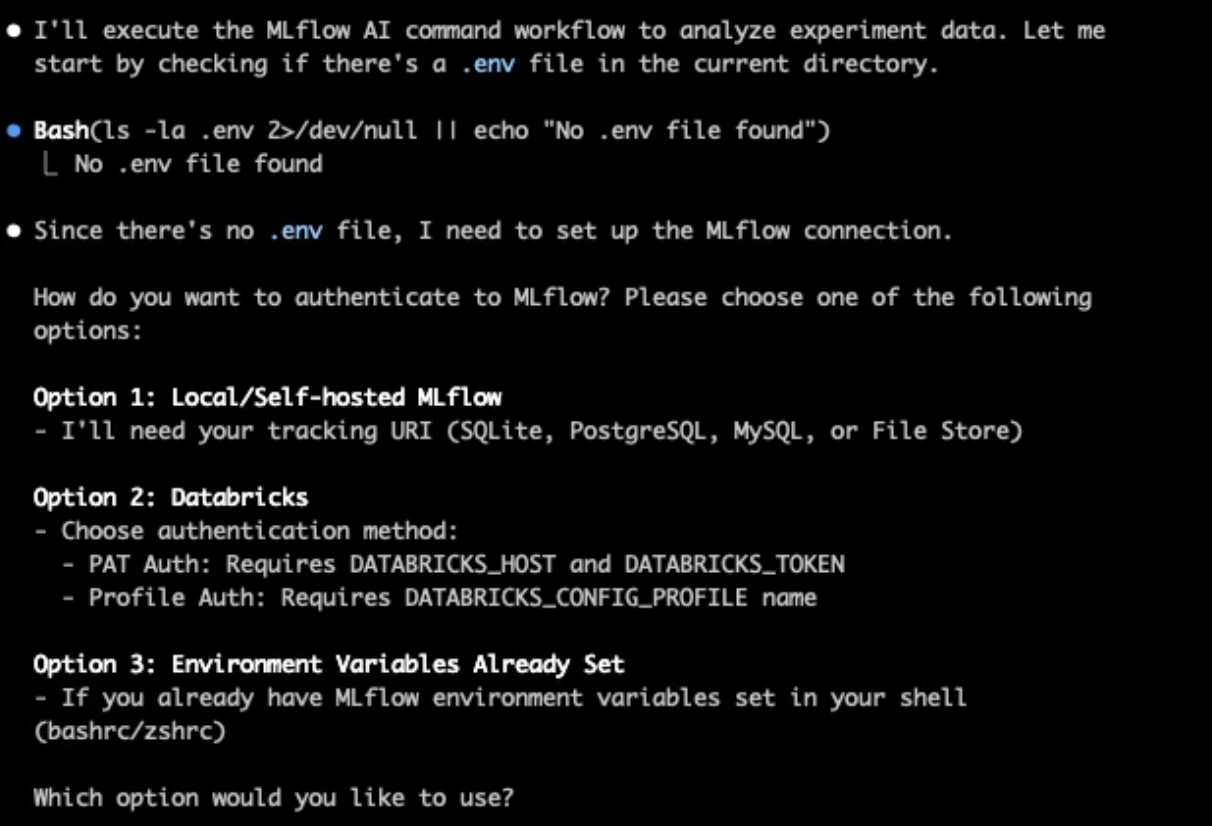

1. 设置和身份验证

该工具将要求您配置身份验证

- Databricks:提供工作区 URL 和个人访问令牌,或使用 Databricks CLI profile

- 本地 MLflow:指定跟踪 URI(SQLite、PostgreSQL、MySQL 或文件存储)

- 环境变量:使用预先配置的 MLflow 环境变量,如

MLFLOW_TRACKING_URI(参见 环境变量设置指南)

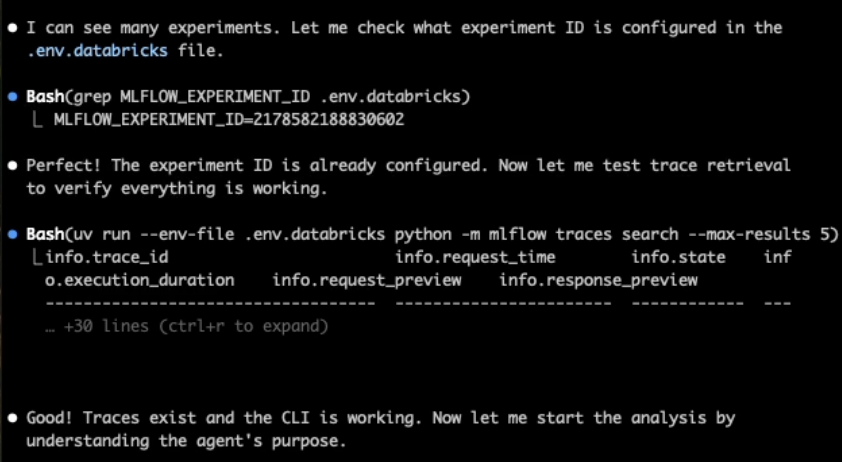

2. 实验选择

- 浏览可用实验或按名称搜索

- 选择包含要分析的跟踪记录的实验

- 验证跟踪记录的可用性和数据结构

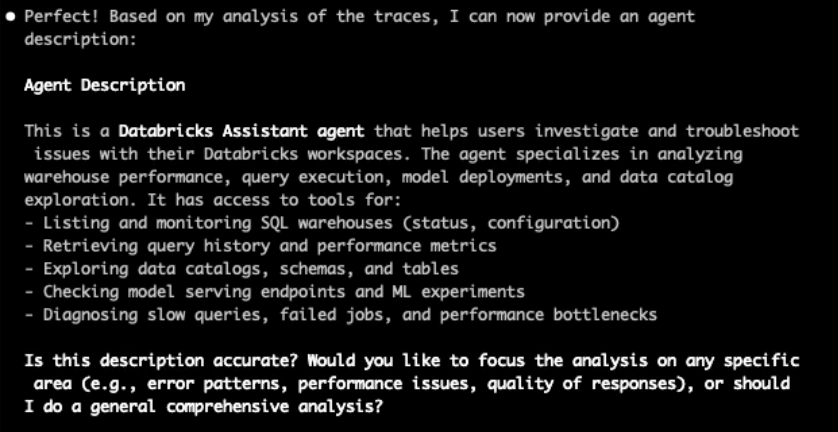

3. 代理目的识别

该工具会检查跟踪记录的输入和输出,以了解

- 您的代理的工作是什么(例如,“一个帮助用户解决账单问题的客服代理”)

- 代理可以访问哪些数据源和工具

- 用户交互中的常见模式

在分析继续之前,您将被要求确认或更正此理解。

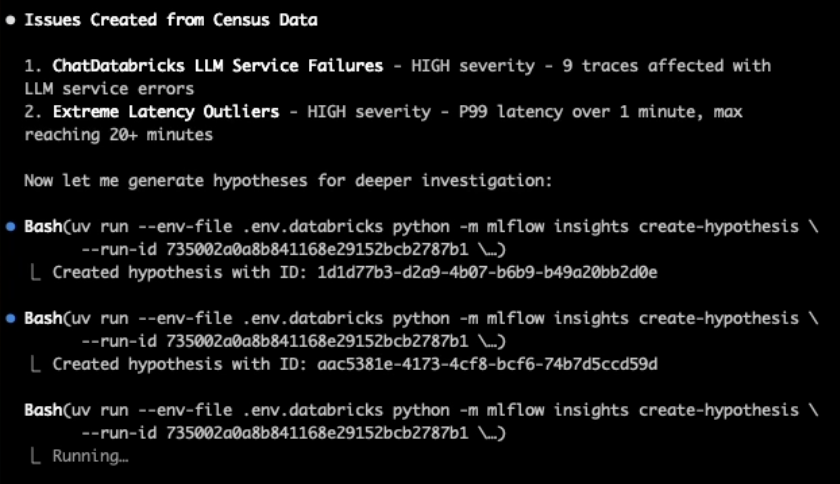

4. 假设驱动的分析

该工具会系统地测试有关潜在问题的假设

运维问题:

- 错误模式(身份验证失败、超时、API 故障)

- 性能瓶颈(缓慢的工具调用、顺序执行与并行执行)

- 速率限制和资源争用

质量问题:

- 内容问题(冗长、重复、不一致)

- 响应与查询类型的匹配度

- 上下文处理和对话流程

5. 报告生成

该工具将生成一份全面的 markdown 报告,其中包含

- 汇总统计信息:成功率、延迟指标、错误分布

- 已确认的问题:详细分析,包括具体的跟踪示例和根本原因

- 优点:您的应用程序中哪些方面运行良好

- 建议:基于发现的可操作性改进

报告内容

每份生成的报告都提供了对您的应用程序行为的全面见解

量化指标

关键性能指标,包括分析的总跟踪数、成功率(OK vs ERROR)、延迟统计信息(平均值、中位数、P95)和错误率分布

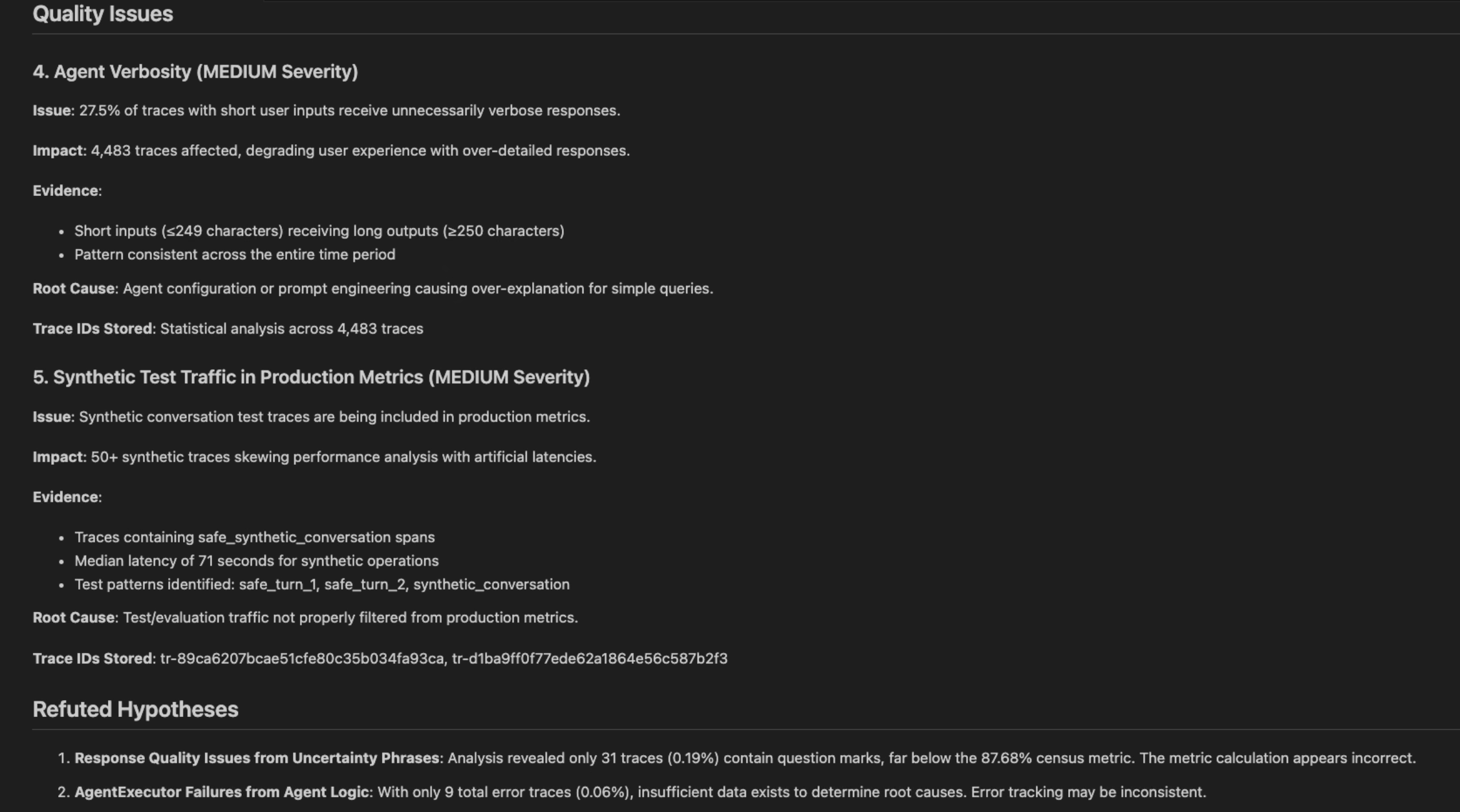

问题分析

已确认问题的详细分类,包括问题陈述、包含输入/输出的跟踪示例、根本原因分析、频率评估和用于调查的具体跟踪 ID

可操作的建议

优先的改进建议,附带实施指南和预期影响,帮助您系统地解决已识别的问题