MLflow Tracing,助力 LLM 可观测性

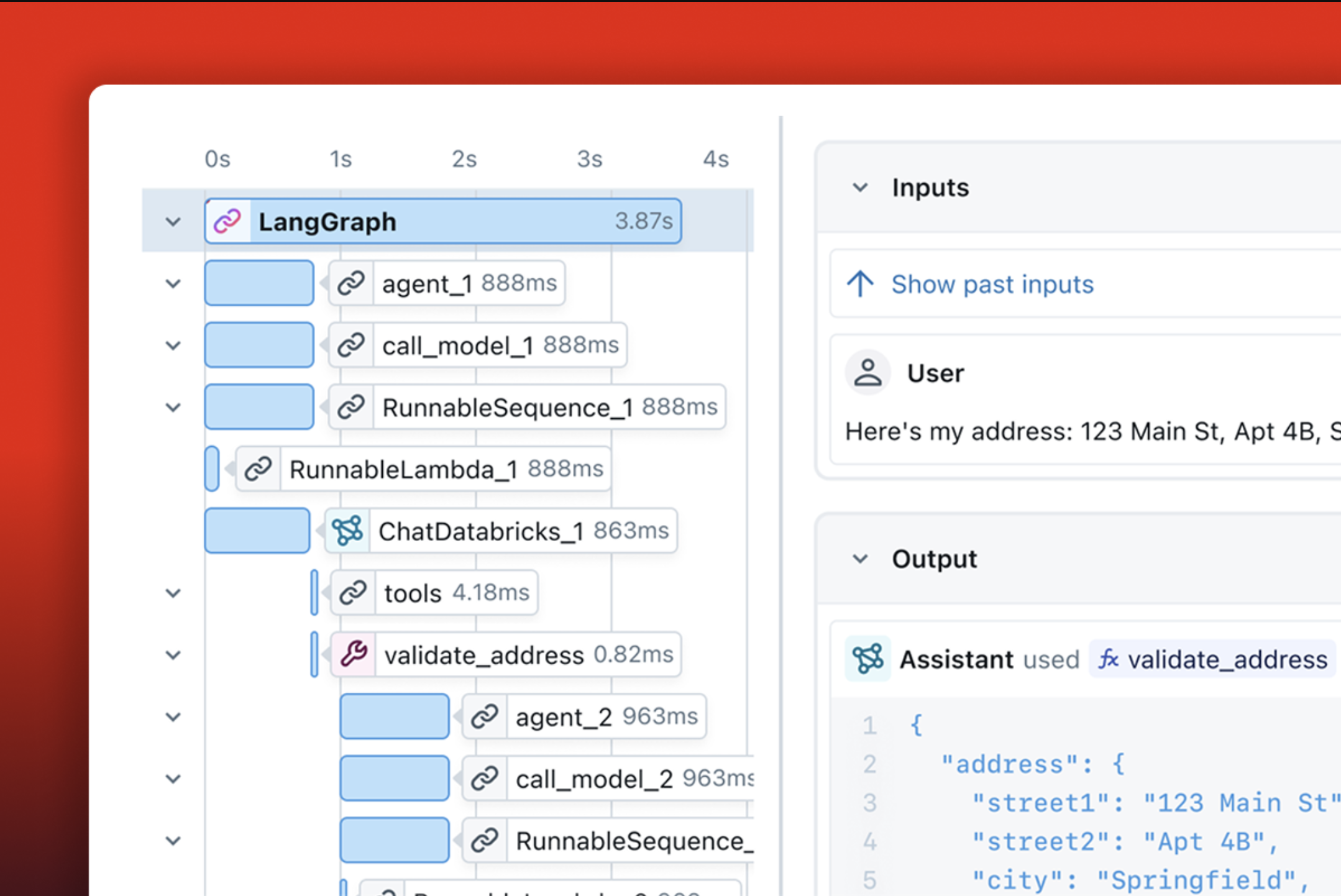

MLflow Tracing 是一个完全 **兼容 OpenTelemetry** 的 LLM 可观测性解决方案,适用于您的应用程序。它可以捕获请求的每个中间步骤相关的输入、输出和元数据,让您能够轻松地精确定位 bug 和意外行为的根源。

贯穿 ML 生命周期的用例

MLflow Tracing 在机器学习项目的整个生命周期中为您提供支持。以下是它在工作流的每个步骤中的帮助方式,请点击下方的选项卡了解更多信息

- 构建和调试

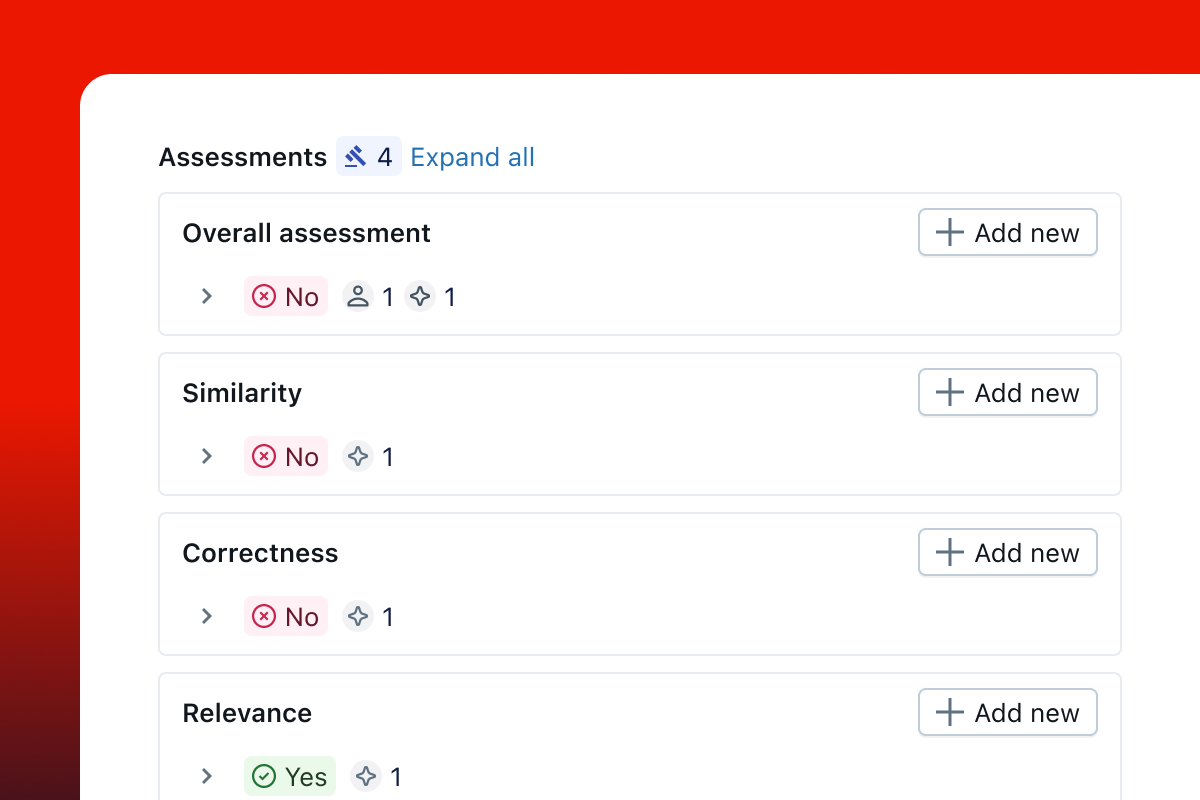

- 人工反馈

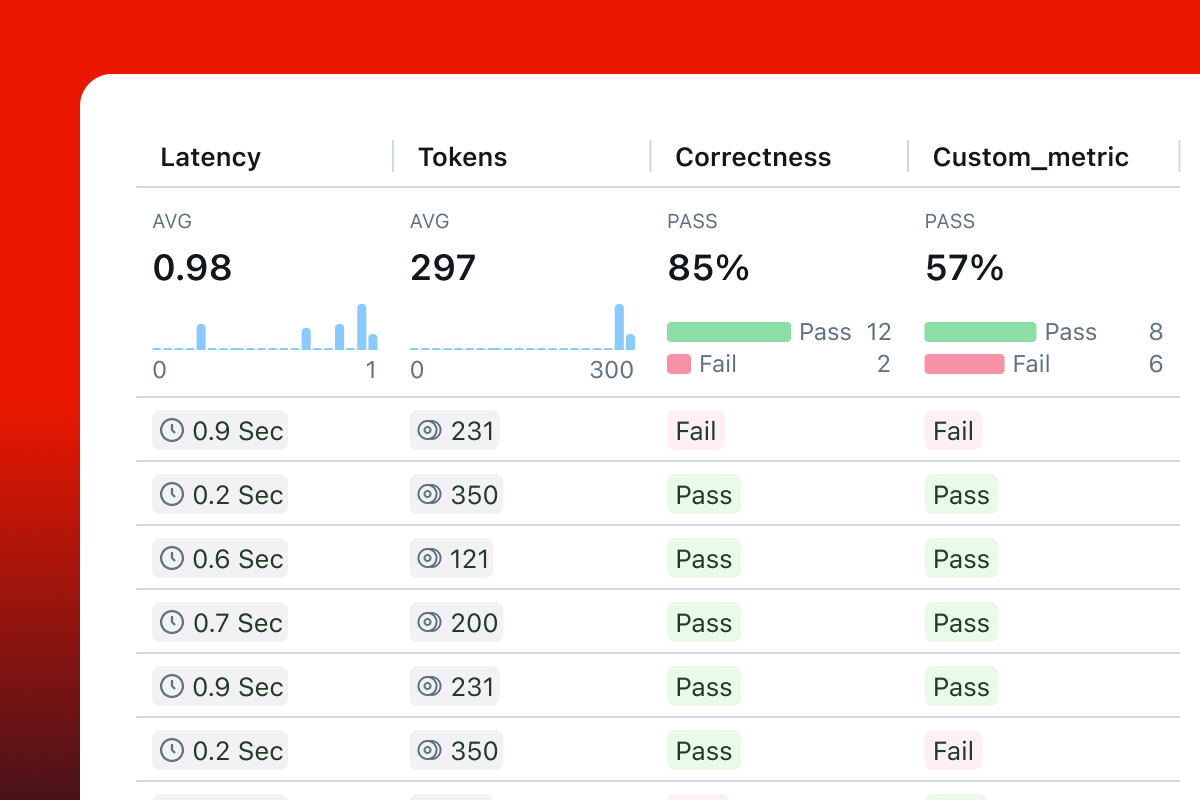

- 评估

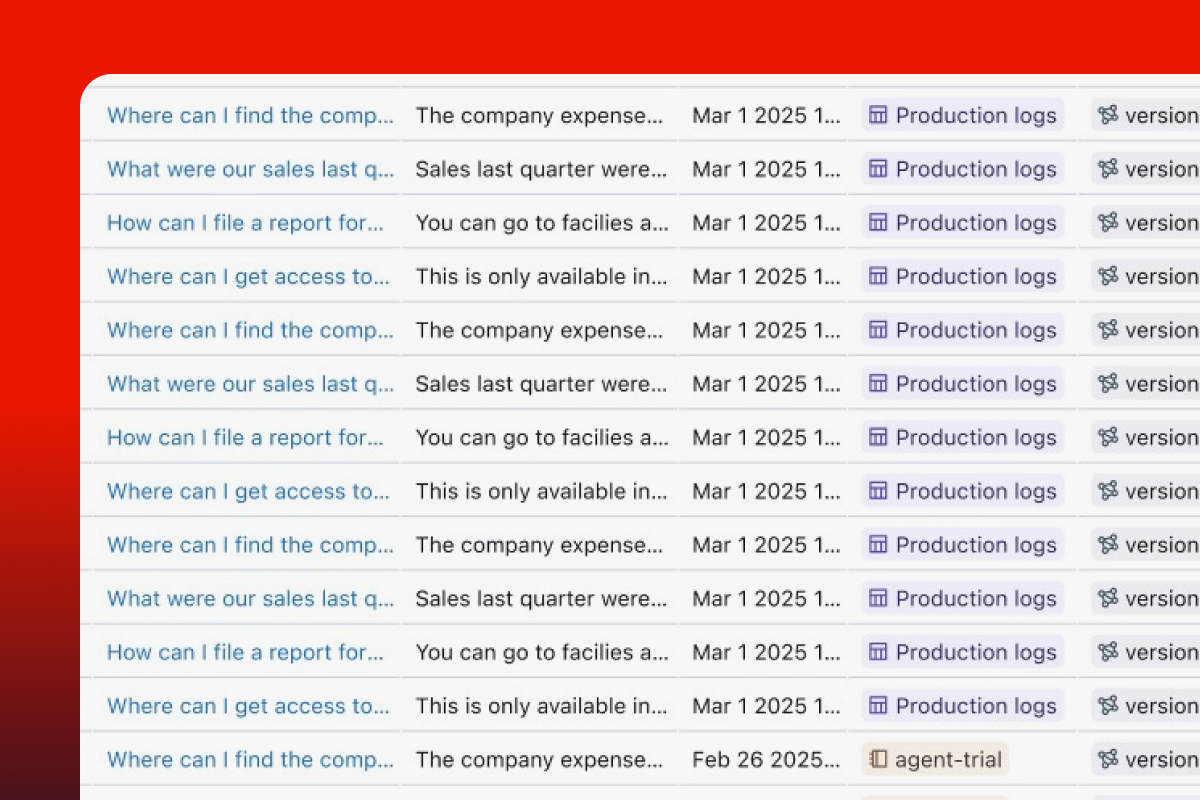

- 生产监控

- 数据集收集

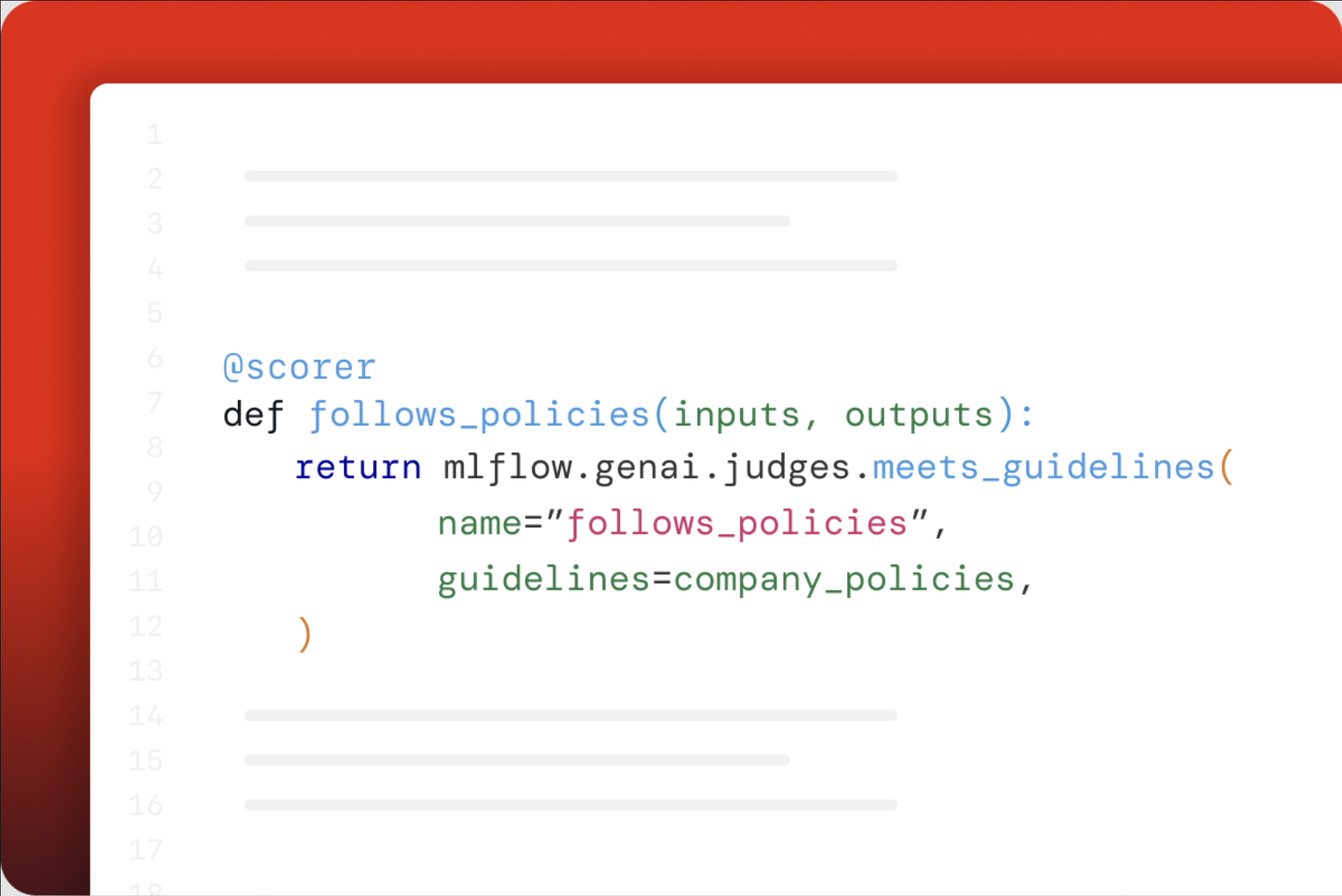

评估和提高质量

系统地评估和改进 GenAI 应用程序的质量是一项挑战。结合 MLflow GenAI Evaluation,MLflow 提供了无缝的应用程序评估体验。

Tracing 通过允许您追踪质量评估并检查评估结果,同时提供对系统内部机制的可见性,从而提供帮助。

MLflow Tracing 的独特之处是什么?

开源

MLflow 是开源且 100% 免费的。您无需支付额外的 SaaS 费用即可为您的 GenAI 技术栈添加可观测性。您的 Trace 数据托管在您自己的基础设施上。

OpenTelemetry

MLflow Tracing 完全兼容 OpenTelemetry,避免了供应商锁定,并且易于与您现有的可观测性技术栈集成。

框架无关

MLflow Tracing 集成了 20 多个 GenAI 库,包括 OpenAI、LangChain、LlamaIndex、DSPy、Pydantic AI,让您能够轻松地在不同框架之间切换。

端到端平台

MLflow Tracing 在整个机器学习生命周期中为您提供支持,并结合了版本追踪和评估能力。

强大的社区

MLflow 作为 Linux Foundation 的一部分,拥有一个充满活力的开源社区,拥有 20K+ GitHub Star 和 2000 万+ 月下载量。

开始使用

快速入门 (Python)

使用 Python 开始 MLflow Tracing

快速入门 (JS/TS)

使用 JavaScript 或 TypeScript 开始 MLflow Tracing

快速入门 (Otel)

将 OpenTelemetry 仪表化的应用程序的 Traces 导出到 MLflow。

单行自动 Tracing 集成

MLflow Tracing 已与各种 GenAI 库集成,并为每个库(以及它们的组合!)提供单行自动 Tracing 体验。

import mlflow

mlflow.openai.autolog() # or replace 'openai' with other library names, e.g., "anthropic"

点击下方图标了解更多关于各个集成的信息

灵活且可定制

除了单行自动 Tracing 体验外,MLflow 还提供 Python SDK,用于手动仪表化您的代码和操作 Traces。

- 使用

@mlflow.trace装饰器追踪函数 - 追踪任意代码块

- 组合多个自动 Tracing 集成

- 仪表化多线程应用程序

- 原生异步支持

- 使用 Session 对 Traces 进行分组和过滤

- 从 Traces 中红字化 PII 数据

- 全局禁用 Tracing

- 配置采样率以控制 Trace 吞吐量

生产就绪

MLflow Tracing 已准备好投入生产,并为您的生产环境中的 GenAI 应用程序提供全面的监控功能。通过启用 异步日志记录,Trace 日志记录在后台进行,不会影响您的应用程序性能。

对于生产部署,建议使用 轻量级 Tracing SDK (mlflow-tracing),该 SDK 经过优化,可减小总安装大小并最小化依赖项,同时保持完整的 Tracing 功能。与完整的 mlflow 包相比,mlflow-tracing 包的占地面积减少了 95%。

阅读 生产环境监控 以获取关于使用 MLflow Tracing 监控生产环境中模型以及各种后端配置选项的完整指南。