MLflow Tracing 实现 LLM 可观测性

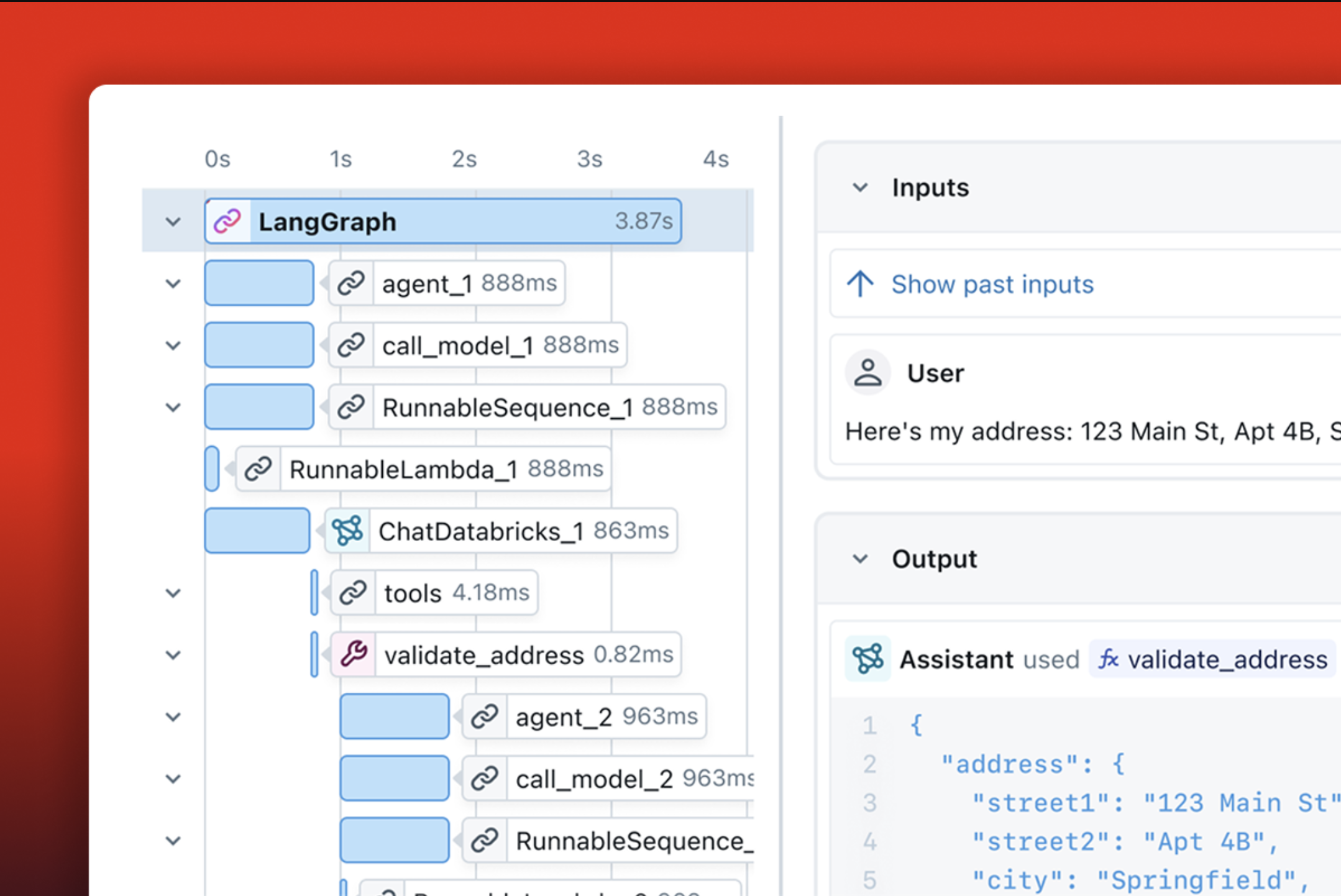

MLflow Tracing 通过捕获与请求的每个中间步骤相关的输入、输出和元数据,增强了您应用程序中的 LLM 可观测性,使您能够轻松查明错误和意外行为的来源。

贯穿机器学习生命周期的用例

MLflow Tracing 在机器学习项目的整个端到端生命周期中为您提供支持。以下是它在工作流程的每个步骤中如何帮助您,点击下面的选项卡了解更多信息

- 构建与调试

- 人工反馈

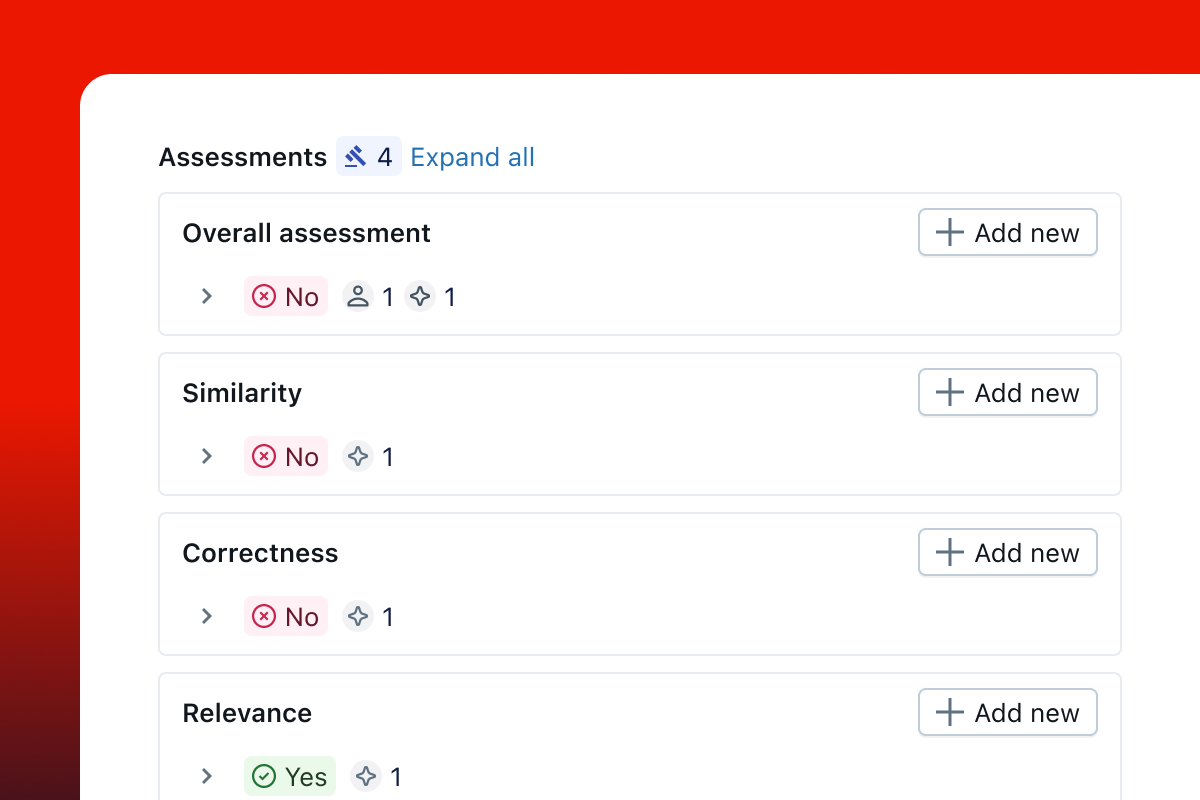

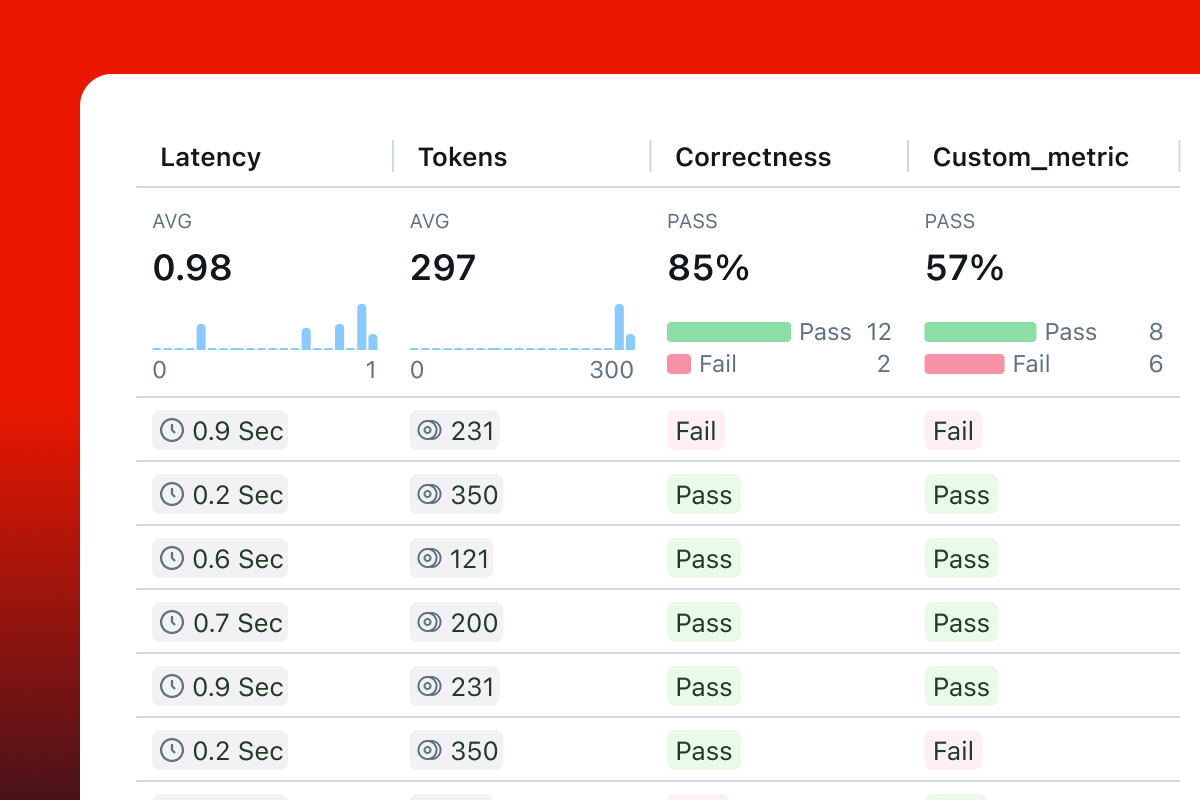

- 评估

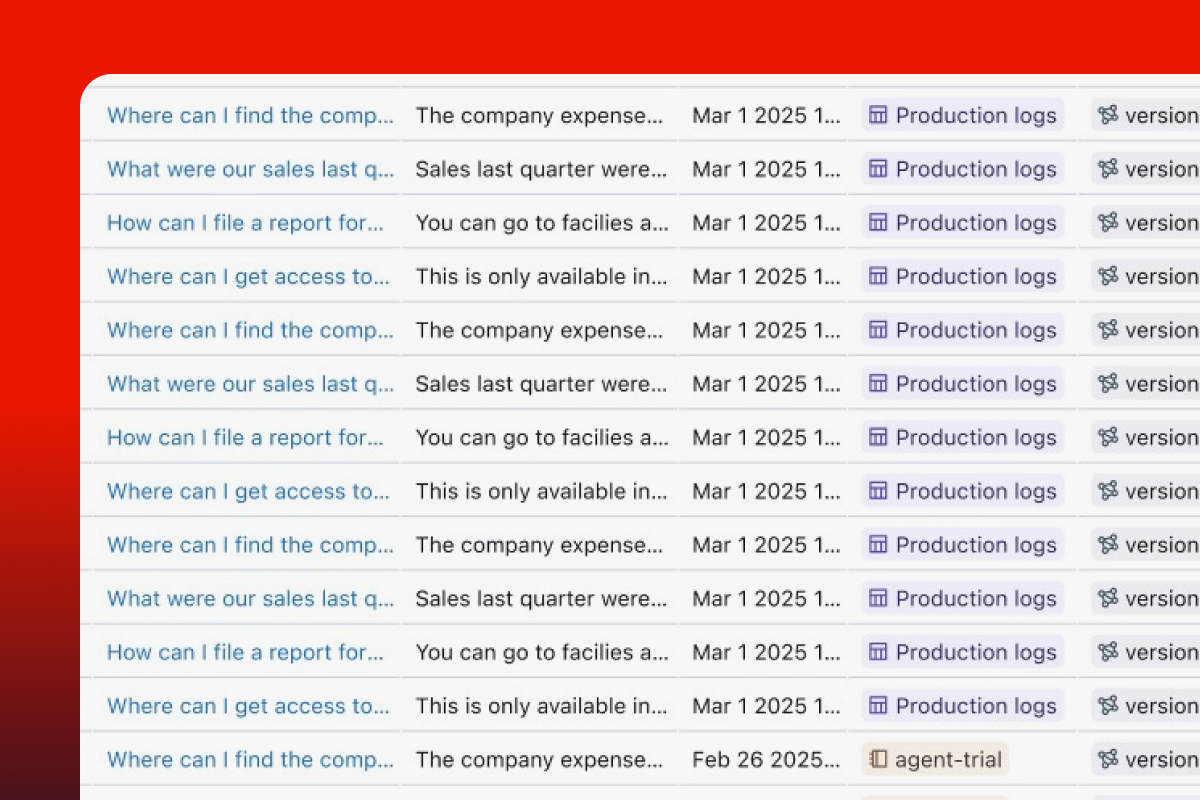

- 生产监控

- 数据集收集

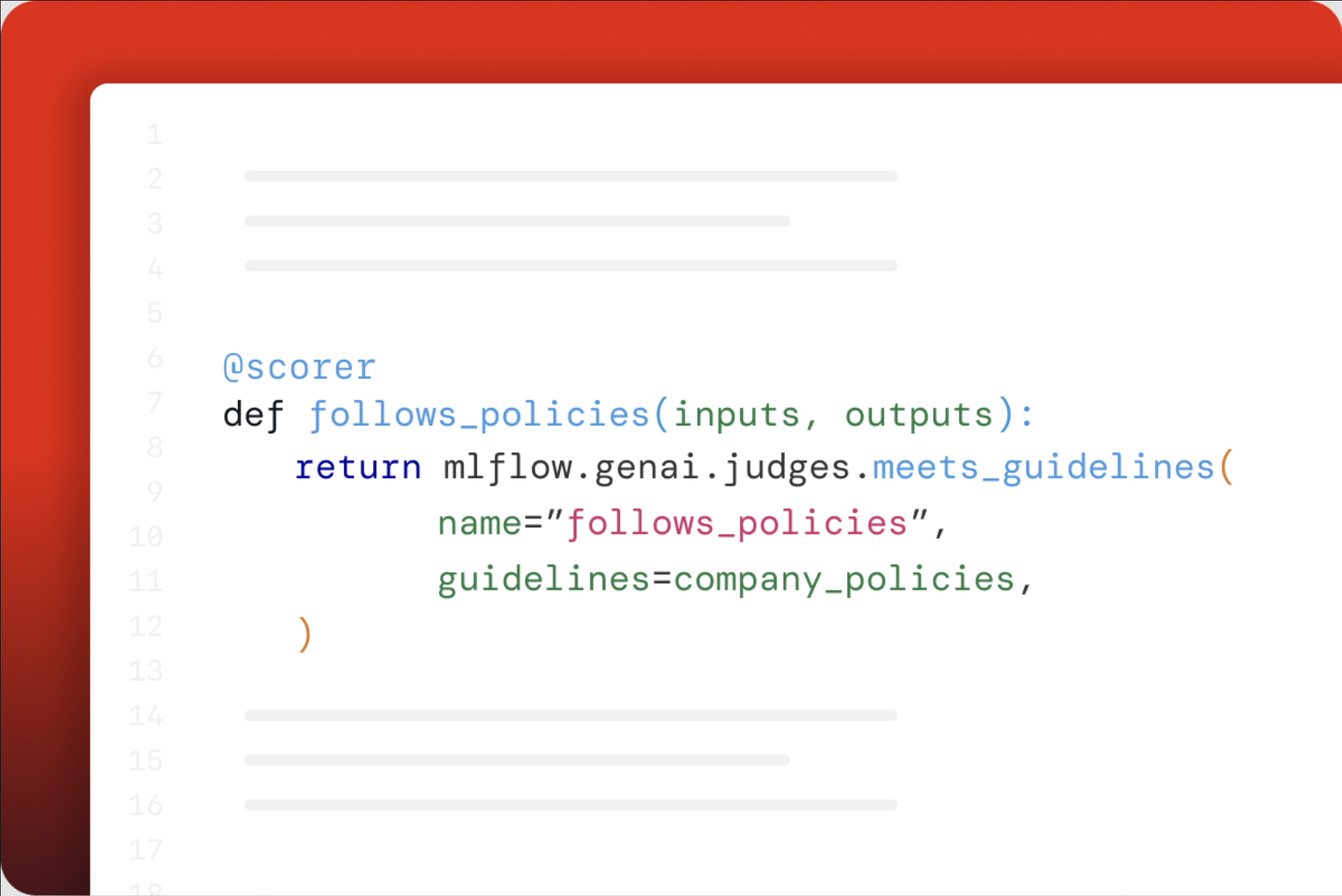

评估和提升质量

系统地评估和改进 GenAI 应用程序的质量是一项挑战。结合 MLflow GenAI 评估,MLflow 为评估您的应用程序提供了无缝的体验。

Tracing 通过允许您跟踪质量评估并检查评估结果,同时提供对系统内部的可见性来提供帮助。

是什么让 MLflow Tracing 与众不同?

开源

MLflow 是开源且 100% 免费的。您无需支付额外的 SaaS 成本即可为您的 GenAI 技术栈添加可观测性。您的 Trace 数据托管在您自己的基础设施上。

OpenTelemetry

MLflow Tracing 与 OpenTelemetry 兼容,使其不受供应商锁定的限制,并易于与您现有的可观测性技术栈集成。

框架无关

MLflow Tracing 集成了 20 多个 GenAI 库,包括 OpenAI、LangChain、LlamaIndex、DSPy、Pydantic AI,让您可以轻松地在不同框架之间切换。

端到端平台

MLflow Tracing 结合其版本跟踪和评估功能,在整个端到端机器学习生命周期中为您提供支持。

强大的社区

MLflow 作为 Linux 基金会的一部分,拥有一个充满活力的开源社区,拥有超过 2 万个 GitHub Star 和每月超过 2000 万次下载。

开始使用

快速入门 (Python)

在 Python 中开始使用 MLflow

快速入门 (JS/TS)

在 JavaScript 或 TypeScript 中开始使用 MLflow

追踪您的应用

探索为自己的应用程序或系统进行插桩的实践指南

一行代码自动追踪集成

MLflow Tracing 与各种 GenAI 库集成,并为每个库(以及它们的组合!)提供一行代码的自动追踪体验。

import mlflow

mlflow.openai.autolog() # or replace 'openai' with other library names, e.g., "anthropic"

点击下方的徽标以了解有关各个集成的更多信息

灵活且可定制

除了一行代码的自动追踪体验外,MLflow 还提供 Python SDK,用于手动对您的代码进行插桩和操作 Trace。

- 使用

@mlflow.trace装饰器追踪一个函数 - 使用上下文管理器追踪任何代码块

- 结合多个自动追踪集成

- 为多线程应用程序进行插桩

- 原生异步支持

- 使用会话对 Trace 进行分组和过滤

- 从 Trace 中隐去个人可识别信息 (PII) 数据

- 全局禁用追踪

- 配置采样率以控制 Trace 吞吐量

生产就绪

MLflow Tracing 已准备好用于生产环境,并为您的 GenAI 应用程序在生产环境中提供全面的监控功能。通过启用异步日志记录,追踪日志记录在后台完成,不会影响您应用程序的性能。

对于生产部署,建议使用轻量级追踪 SDK (mlflow-tracing),它经过优化,可减少总安装大小并最小化依赖关系,同时保持完整的追踪功能。与完整的 mlflow 包相比,mlflow-tracing 包所需的空间减少了 95%。

阅读生产监控,获取有关使用 MLflow Tracing 监控生产中模型以及各种后端配置选项的完整指南。