跟踪 Ollama

Ollama 是一个开源平台,使用户能够在本地设备上运行大型语言模型 (LLM),例如 Llama 3.2、Gemma 2、Mistral、Code Llama 等。

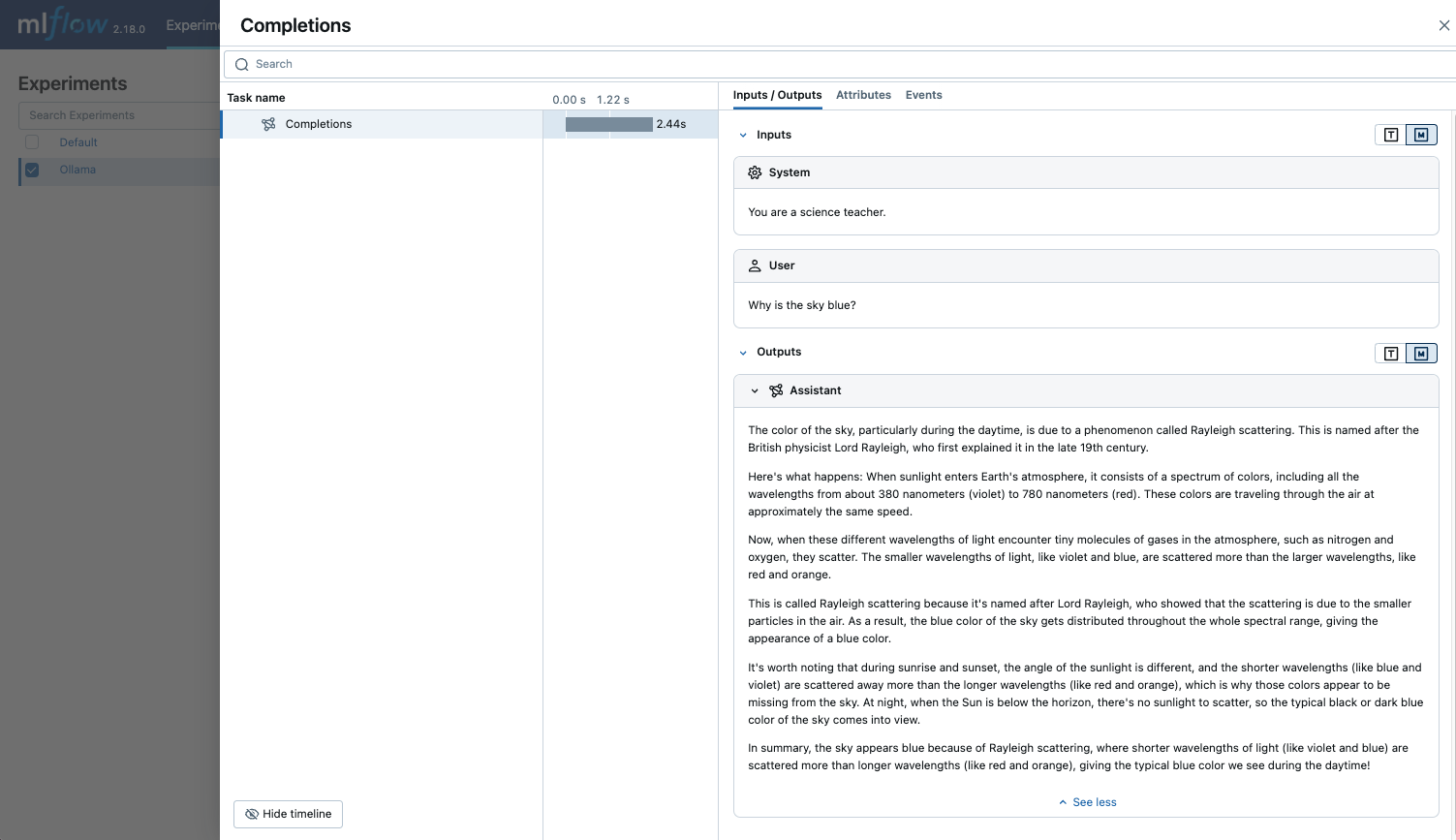

由于 Ollama 提供的本地 LLM 端点与 OpenAI API 兼容,您可以通过 OpenAI SDK 查询它,并使用 mlflow.openai.autolog() 为 Ollama 启用跟踪。通过 Ollama 进行的任何 LLM 交互都将记录到活动的 MLflow Experiment 中。

import mlflow

mlflow.openai.autolog()

示例用法

- 使用所需的 LLM 模型运行 Ollama 服务器。

ollama run llama3.2:1b

- 为 OpenAI SDK 启用自动跟踪。

import mlflow

# Enable auto-tracing for OpenAI

mlflow.openai.autolog()

# Optional: Set a tracking URI and an experiment

mlflow.set_tracking_uri("https://:5000")

mlflow.set_experiment("Ollama")

- 查询 LLM 并在 MLflow UI 中查看跟踪信息。

from openai import OpenAI

client = OpenAI(

base_url="https://:11434/v1", # The local Ollama REST endpoint

api_key="dummy", # Required to instantiate OpenAI client, it can be a random string

)

response = client.chat.completions.create(

model="llama3.2:1b",

messages=[

{"role": "system", "content": "You are a science teacher."},

{"role": "user", "content": "Why is the sky blue?"},

],

)

禁用自动跟踪

可以通过调用 mlflow.openai.autolog(disable=True) 或 mlflow.autolog(disable=True) 全局禁用 Ollama 的自动跟踪。